Roboter werden häufig von Suchmaschinen verwendet, um Dateien von Websites zu kategorisieren, oder von Webmastern, um den Quellcode zu korrigieren oder zu filtern. Die robots.txt-Datei enthält bestimmte Anweisungen, die erfüllt sein müssen.

Analysieren und spezifizieren wir den Quellcode einer robots.txt:

Allen Robotern erlauben, alle Dateien zu besuchen, die im Stammverzeichnis des Webs gespeichert sind:

User-Agent: * Verbieten:

Verhindern Sie den Zugriff auf alle Robots und alle Dateien, die im Stammverzeichnis gespeichert sind:

User-Agent: * Verbieten: /

Erlaube nur einem Roboter den Zugriff, in diesem Beispiel kann nur Google verfolgen

User-Agent: googlebot Verbieten: User-Agent: * Verbieten: /

Die bekanntesten Roboter haben einen Namen, den sie im User-Agent verwenden können

googlebot => für Google

msnbot => MSN Suche

Yahoo-Slurp => Yahoo

scrubby => Scrubbe das Web

robozilla => DMOZ Checker

ia_archiver => Alexa / Wayback

Baiduspider => Baidu

Es gibt auch spezifischere Roboter wie Image

googlebot-image => Google Image

googlebot-mobile => Google Mobile

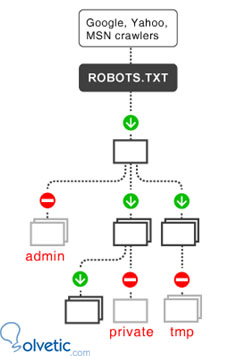

Ein weiteres Beispiel, damit alle Unterverzeichnisse, die den Platzhalter (/) enthalten, blockiert werden müssen, nur diese, mit Ausnahme aller anderen Dateien und Verzeichnisse, die keinen Platzhalter enthalten, werden die Systemverzeichnisse oder das Back-End blockiert:

User-Agent: * Disallow: / cgi-bin / Verbieten: / images / Disallow: / tmp / Disallow: / adminstrador /

Verhindert, dass eine bestimmte Datei verfolgt wird

User-Agent: * Disallow: /page.htm

Dies wird häufig verwendet, wenn eine Seite gelöscht werden soll, die 404-Fehler enthält, oder wenn eine Seite aus den Suchergebnissen entfernt werden soll, damit sie nicht verfolgt wird.

Verwalten Sie die Tracking-Häufigkeit von Robotern

In Google Analytics und in den Webmastertools können Sie die Statistiken einsehen. Sie sehen auch, dass einige Roboter manchmal viel Zeit benötigen, um unsere Website zu überprüfen und Anfragen an den Server zu senden. Die Roboter verbrauchen Bandbreite und Ressourcen, als wären sie nur ein anderer Besucher.

Es gibt eine Möglichkeit, dass Roboter nicht außer Kontrolle geraten, das können wir allen sagen

User-Agent: googlebot Crawl-Verzögerung: 30

Hiermit weisen wir den Google-Roboter an, zwischen den einzelnen Scans 30 Sekunden zu warten. Beachten Sie, dass die Crawling-Verzögerung möglicherweise nicht von allen Suchmaschinen, Bing und Google, unterstützt wird, sofern diese dies unterstützen.

Die offizielle Website von robots.txt ist http://www.robotstxt.org/, wo wir die Namen aller Roboter finden, Spezifikationen zum Code. Hier wird offengelegt, dass die Roboter verwendet werden, um diejenigen zu standardisieren, die verfolgt werden müssen, und auf anderen Plattformen verwendet werden, um HTML zu verfolgen und zu validieren, Links zu validieren, Informationen zu indexieren, Inhalte in Suchmaschinen zu aktualisieren und Websites zu schützen.