Die robots.txt-Datei enthält eine Liste von Seiten, die für die Suchmaschine indiziert werden dürfen, wodurch der Zugriff auf bestimmte Suchmaschinen selektiv eingeschränkt wird.

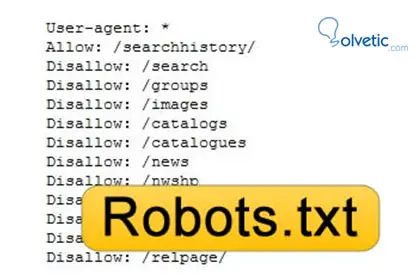

Es ist eine ASCII-Datei, die sich im Stammverzeichnis der Site befinden muss. Die Befehle, die es enthalten kann, sind:

Agent-Benutzer : Hiermit wird festgelegt, welcher Roboter die angezeigten Anweisungen befolgt.

Nicht zulassen : Es wird verwendet, um zu identifizieren, welche Seiten während des Analyseprozesses von der Suchmaschine ausgeschlossen werden. Es ist wichtig, dass jede auszuschließende Seite separate Zeilen sein und auch mit dem Symbol / beginnen muss. Mit dieser Symbologie wird spezifiziert; auf “alle seiten der website”.

Es ist äußerst wichtig, dass die Datei robots.txt keine Leerzeilen enthält.

Es folgen einige Beispiele;

- Wenn Sie alle Seiten ausschließen möchten; Der Agent-Benutzer lautet: Nicht zulassen: /.

- Wenn das Ziel darin besteht, keine Seite auszuschließen, sollte die Datei robotos.txt nicht auf der Website vorhanden sein. Dies bedeutet, dass alle Seiten der Website gleichermaßen besucht werden.

- Wenn ein bestimmter Roboter ausgeschlossen wird, gilt Folgendes:

- Agent-Benutzer: Robotername Nicht zulassen: / Agent-Benutzer: * Nicht zulassen:

- Wenn eine Seite ausgeschlossen wird; Agent-Benutzer: * Nicht zulassen: /directory/path/page.html

- Wenn alle Seiten eines Verzeichnisses der Website mit den entsprechenden Unterordnern ausgeschlossen sind, wird dies der Fall sein. Agent-Benutzer: * Nicht zulassen: / directory /

Mit dieser Datei können Sie verhindern, dass Suchmaschinen auf bestimmte Seiten oder Verzeichnisse zugreifen. Sie können auch den Zugriff auf Dateien oder bestimmte Dienstprogramme blockieren.

Ein weiteres Merkmal ist, die Indizierung von doppeltem Inhalt auf der Website zu verhindern, um nicht bestraft zu werden.

Andere zu beachtende Überlegungen sind, dass einige Roboter die Anweisungen in dieser Datei ignorieren können, und es muss auch klar sein, dass die Datei öffentlich ist, da jeder, der www.example.com/robots.txt schreibt, dies haben kann Zugriff darauf.

Nun kann die Frage sein; Wie erstelle ich die robots.txt-Datei?

Tatsächlich ist es recht einfach, da es sich um ein Textdokument mit dem Namen “robots.txt” handelt und es dann in das Stammverzeichnis der Domain der Seite hochgeladen wird. Dort suchen die Suchmaschinen nach dem Dokument zum Lesen.

Eine grundlegende robots.txt-Datei kann sein:

User-Agent: *

Verbieten: / privat /

Anweisungen werden generiert, um den Zugriff auf ein Verzeichnis zu verweigern, das für alle Suchmaschinen “privat” ist.

Der Befehl stellt fest, dass er an alle Robots gerichtet ist (User-Agent: *), und gibt an, dass das Verzeichnis nicht autorisiert ist (Disallow: / private /).

Der Parameter, der für die Google-Suchmaschine verwendet wird, ist; User-Agent: Googlebot

Wie oben erwähnt, wird seine Verwendung in der Suchmaschinenoptimierung verwendet, um den Zugriff von Robotern auf doppelte Inhalte zu beschränken.